論文紹介: Bridging the Gap Between Value and Policy Based Reinforcement Learning

紹介する論文

Bridging the Gap Between Value and Policy Based Reinforcement Learning

概要

on-policyの学習の安定性とoff-policyのサンプル効率の高さを備えた手法

離散行動空間タスクでA3CやDQNと比べて良い成果をあげた

1. モチベーション

on-policy,off-policy手法の特徴

- on-policyによる学習

→学習の安定性は高いが,サンプル効率が悪い

- off-policyによる学習

→サンプル効率は高いが,学習の安定性は低い

on-policyの安定性とoff-policyのサンプル効率を兼ね備えた手法が理想!!

2.手法

結論から言うと,以下のように表される誤差関数を通して,政策,価値関数を最適化する

学習には,ある部分軌跡 を用いる.

これにより,

- 過去のサンプルの利用によるサンプル効率化

- 確率的な政策の利用による学習の安定化

の2点を実現できる.

1. エントロピー正則化付き強化学習

以下の関数を考える.

ただし,,

は

である.

ここで,は以下のように再帰的に表すことができる.

2. 政策と価値関数の関係性

次に最適な状態価値と政策

の関係について考える.

まず,政策をボルツマン分布で表現すると

となる.

ここでこれを,「1. エントロピー正則化付き強化学習」で導き出したに代入すると

となる.

さらにこれを変形すると,

最後に,この式をの分母に代入すると

となる.

3. 誤差関数の導出

先ほどのの式に対して,両辺に対数をとって変形すると

の方程式が得られる.

さらに,に関して,tステップ目まで展開すると以下のようになる.

ここで,この方程式が成立する状態価値関数,政策が最適であるため,この方程式の左辺と右辺の2乗誤差を誤差関数とする! (両辺が等しい→両辺の差が0→両辺の二乗誤差を誤差関数として最小化を目指す!)

3.メリット

1. サンプル効率が高い

誤差関数が全ての部分軌跡で成立するように学習を行う →リプレイバッファで格納した過去の軌跡を利用することができる(サンプル効率の向上)

2.政策の学習の安定性が高い

従来のoff-policy手法・・・Q学習をベースとしていたため,行動評価が決定的で不安定

本手法・・・行動評価が決定的でなく,かつエントロピー正則化により探索不足による収束の不安定性も緩和!

4.まとめ

エントロピー正則化付き強化学習の考え方により,on-policyとoff-policyのメリットを共存させたアルゴリズムを開発した

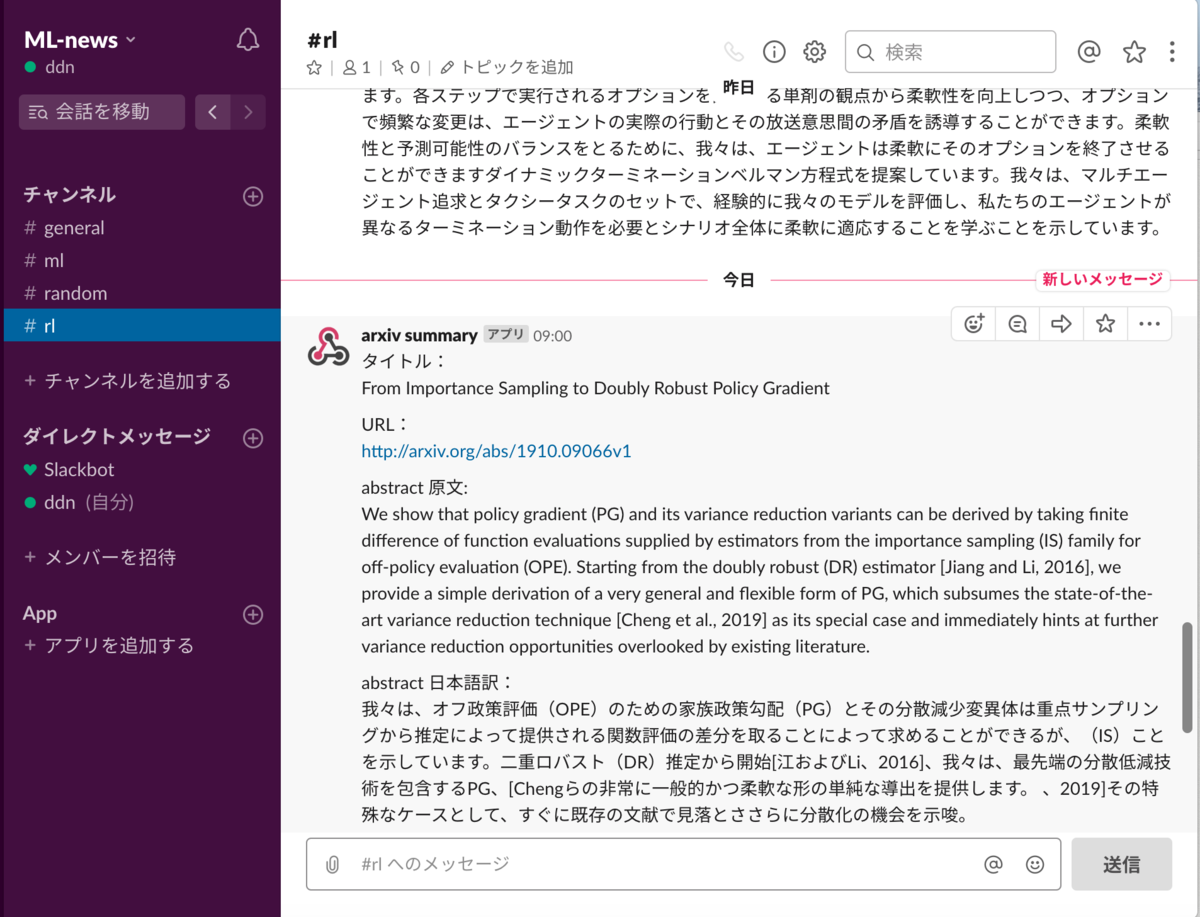

arxivライブラリを用いたSlackでの翻訳bot

「arxivAPIを叩いてsummaryをとってきて,その翻訳結果をSlackに投げる」という内容のブログが既に多く公開されています.

ただ,Pythonのarxivライブラリを用いて処理を行なっているものが見当たらなかったため,これを用いて簡単に行う方法を掲載します.

流れとしては以下の通りです.

- arxivライブラリを用いてを情報を抽出する

- Googletranslatorライブラリを用いて翻訳

- Slackへ翻訳結果を返す

実行例

さらに,herokuを用いて定期実行を設定することで,定期的に翻訳結果をslackに返すことができます.

1. arxivライブラリによるsummaryの抽出

はじめに,arxivライブラリを用いてsummaryの情報を抽出します.

今回は以下のようなフォーマットにするため,

- タイトル

- URL

- summary

の3つを抽出します.

''タイトル:

{}

URL:

{}

abstract 原文:

{}

abstract 日本語訳:

{}

arxiv.queryで情報を抽出します.今回は例として「off policy」という用語がabstractに含まれている論文のなかで,最も新しいものを1つ抽出します.

l = arxiv.query(query='abs:"off policy"',max_results=1,sort_by="lastUpdatedDate")

また,抽出したデータに対してKeyを指定することで,狙ったデータをさらに抽出することができます.詳しくは以下のリンク先をご参照ください.

https://note.nkmk.me/python-arxiv-api-download-rss/

今回は.[“title”],[“id”],[“summary”]でタイトル,URL,abstractを抽出します.

title=l[0]["title"] url=l[0]["id"] summary_en=l[0]["summary"]

実装コードまとめ

import arxiv import time l = arxiv.query(query='abs:"off policy"',max_results=1,sort_by="lastUpdatedDate") #情報の抽出 title=l[0]["title"] url=l[0]["id"] summary_en=l[0]["summary"]

2. Googletranslatorライブラリを用いて翻訳

次に,抽出したデータを翻訳します.翻訳にはGoogletranslatorを用います.

from googletrans import Translator translator = Translator()

ここで,単に抽出したデータを翻訳関数に渡すと,改行により翻訳精度が落ちるため

summary_en = summary_en.replace('\n', ' ')

によって,改行を省きます.

翻訳はGoogletranslatorインスタンスのtranslate関数に,(翻訳したい文章,翻訳後の言語)を渡すことで行えます.

summary=translator.translate(summary_en,dest="ja").text

実装コードまとめ

from googletrans import Translator translator = Translator() summary_en = summary_en.replace('\n', ' ') summary=translator.translate(summary_en,dest="ja").text

3. slackへ翻訳結果を送信

次に,2で翻訳した結果をslackに送信します.

そのために,slackの拡張機能である「Incomming Webhook」を用います.

Incomming Webhookの設定

簡単に説明すると,以下の手順でWebhook URLを取得するのが目的となります.

- Slackをインストールし,チャンネルを作成する

- slackアプリストアの検索エンジンで「incoming-webhooks」を検索しページに飛ぶ

- incoming-webhooksを設定に追加する

4.最後に得られる「Webhook URL」をコピーしておく

実装コード

まず,Webhook URLを変数に格納します.

slack_url ='Webhook URL'

続いて,2での翻訳結果を含めたタイトルなどの情報を,1で示したフォーマットにして変数に格納します.

text = '''タイトル: {} URL: {} abstract 原文: {} abstract 日本語訳: {} '''.format(title, url, summary_en,summary)

最後に,json形式で「requests.post」で渡して,slackに翻訳結果を送信します.

data = json.dumps({

'username': 'arxiv summary',

'text': text

})

requests.post(slack_url, data=data)

実装コードまとめ

import requests import json slack_url ='https://hooks.slack.com/services/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' text = '''タイトル: {} URL: {} abstract 原文: {} abstract 日本語訳: {} '''.format(title, url, summary_en,summary) data = json.dumps({ 'username': 'arxiv summary', 'text': text }) requests.post(slack_url, data=data)

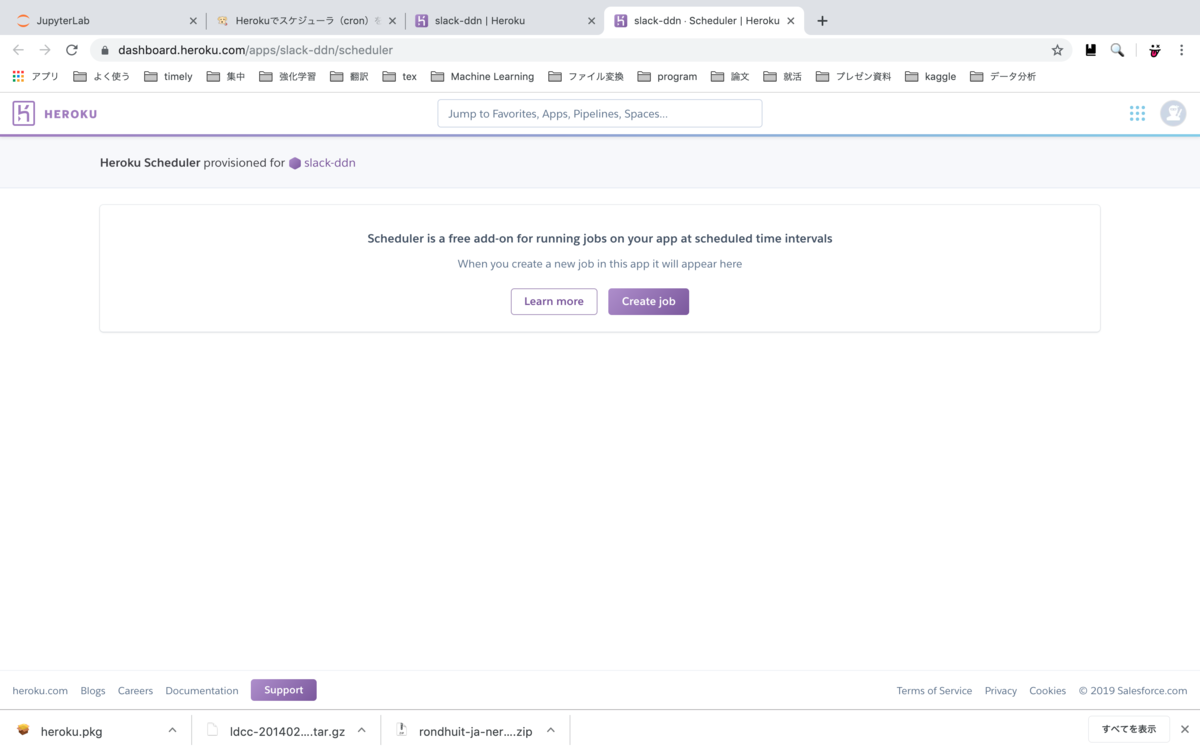

4. herokuによる定期的に実行

定期的に実行するためにherokuを用います.

準備

会員登録をしてから以下の手順でコマンドを実行してください

- heroku login

- heroku create -a 任意の名前

- heroku buildpacks:set heroku/python -a 2で決めた名前

- 必要なライブラリが記述されたファイルを「requirements.txt」として作成

- git init

- heroku git:remote -a アプリ名 1.git add .

- git commit -m ‘init’

- git push heroku master

requirements.txtの中身

arxiv==0.5.1 googletrans==2.4.0 requests==2.21.0

テスト

ファイル名をmain.pyとした場合

heroku run python main.py

でプログラムが動作すればok

定期実行

- heroku addons:create scheduler:standard --app アプリ名

- heroku addons:open scheduler

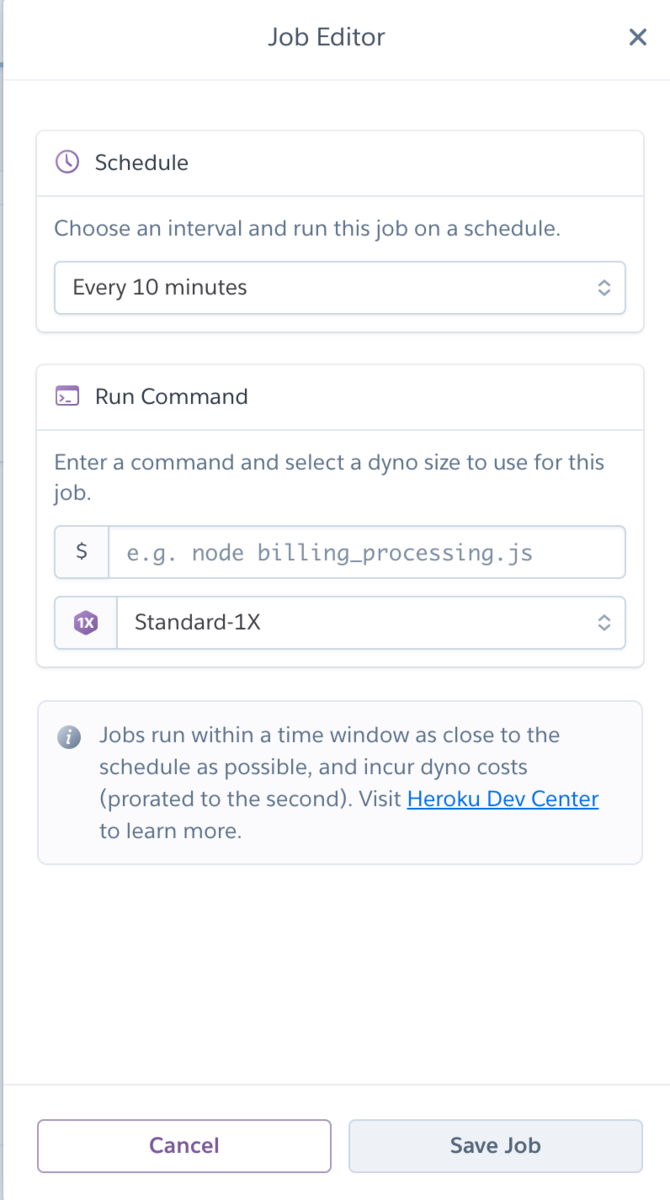

- 以下の画面がブラウザで開くため,「Create job」をクリック

4.「Choose an 〜〜」で実行頻度を設定,「Run Command」で実行コマンドを記述

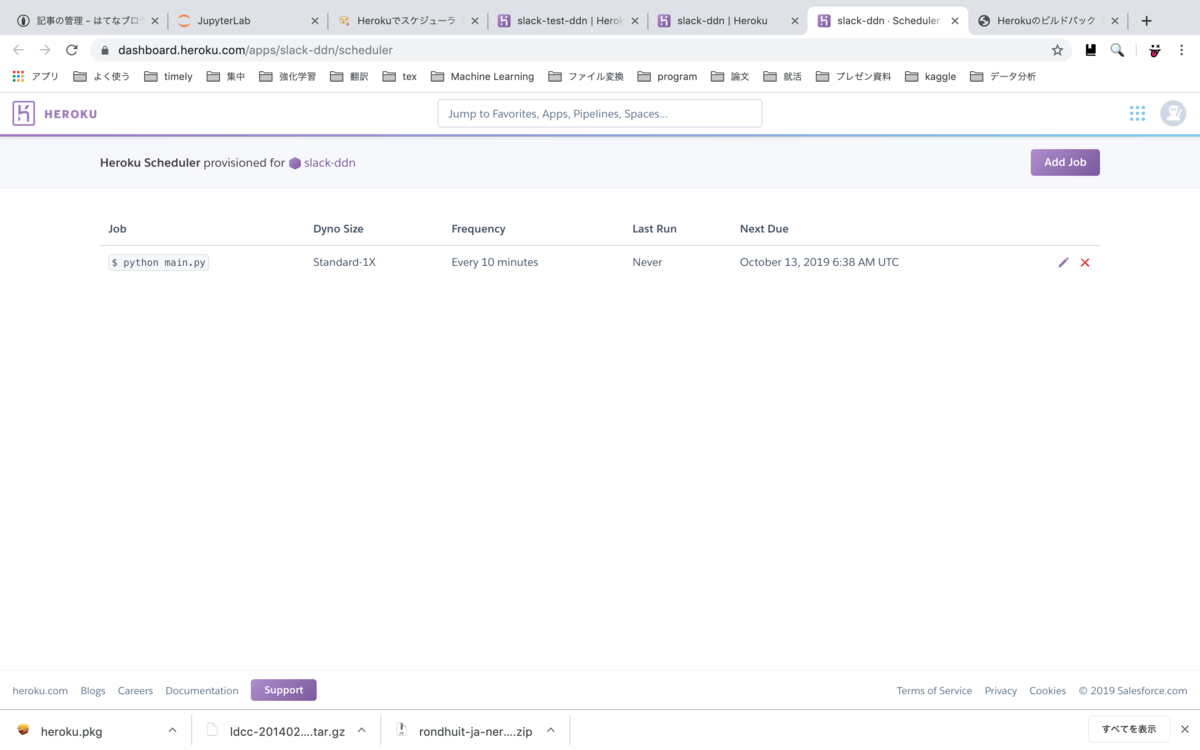

5.以下の画面でscheduleを確認

まとめ

arxivで取得した文章を翻訳し,Slackに送信するプログラムを定期的に実行する方法を掲載しました. また,文章取得はarxivライブラリ,翻訳モデルはgoogletranslatorを用いるため,簡潔に実装することができました. 今後は,翻訳モデルを自分で構築して,自然言語処理の知見を高めようと考えております.

論文紹介:Reverse Curriculum Generation for Reinforcement Learning

紹介する論文

Reverse Curriculum Generation for Reinforcement Learning

概要

目標地点付近で目標を達成しやすい状態を初期状態とする(徐々に初期位置に近づける)

逆順に学習を行うことで,最終ゴールを知ることができ,局所解に陥りにくくなる

単純な初期状態の場合にほぼ達成できないタスクで,比較的高い成功率を誇る

1. モチベーション

強化学習における報酬設定に関する問題

スパースな報酬設定での学習

→高次元空間を探索する場合,報酬が得られる頻度が極めて少なく(得られない場合も...),学習が進まない.密な報酬設定での学習

→報酬設定のエンジニアリングが難しい

提案法

スパースな報酬設定において,初期状態を目標地点に近い状態とする!!

- 目標地点の近くからエピソードを開始し,目標地点に到達する確率が高いため,スパースな報酬設定でも学習が進むと期待できる.

2. 仮定

提案法は,以下の3つの仮定をおいている.

すべてのエピソードの開始時に、エージェントを任意の開始状態

にリセットできる

となるような、少なくとも1つの状態

が存在する,つまり,最終状態が1つは存在する.

すべての開始状態

と与えられた目標状態

は任意の行動によって遷移可能である.

3.良い初期状態の定義

良い初期状態を,「エージェントが時々目標に到達するが、常にではない状態」と定義する.

ここで,スパース報酬設定の場合,を以下のように定義すると,ある時間ステップ内で目標を達成する確率を表す.

このを利用して,

を満たすような初期状態

を出来るだけ利用する.

(,

はハイパーパラメータ.成功確率の限界値を表す)

4. ゴール近くの初期状態の生成方法

初期状態の生成のために、直接,ゴール状態にノイズを加えると

- 取り得ない状態を生成してしまう可能性がある

- 各次元においては大した変化でなくても、全体としては大きくずれるような状態の可能性がある

以上の2点より,直接,ゴール状態にノイズを加えるのはよくない.

よって,一定ステップの間ノイズ的な行動を行い、実際に行動した結果を新たな初期状態として生成する.

5. 手法全体のアルゴリズム

- 「ゴールから

ステップの間,ランダムに行動を行なって,新たな状態を取得し

に格納」を繰り返す.

がMとなるまで,1を繰り返す

の中 から,

個サンプリングし、今回の初期状態抽出バッファ

に加える

- 前のイテレーションで格納したバッファ

から

個を

に加える(この

によって加えるサンプルは

以上

以下の条件を満たすサンプル)

から初期状態を抽出して学習を行う

から「

以上

以下のサンプル」を選択し、次の更新で用いる

として保存しておく

今後の展望

事前知識を生成された開始分布ρiに反映させる

以下の論文の手法と組み合わせてみると良いかもね

https://arxiv.org/pdf/1705.06366.pdf

個人的に気になる点

- 論文内では「任意のon-policy手法で用いることができる」と記述があるが,off-policyでも利用可能に思えるが??